Octopus-v2大模型,一款可以跑在安卓手机上的AI模型

大型语言模型(LLMs)在云环境中表现出色,但存在隐私和成本方面的担忧。为了解决这些问题,研究者们开发了更小的模型以部署在边缘设备上,如智能手机、汽车、VR头显和个人电脑。

今天介绍一个能在手机端运行的AI大模型:Octopus V2

Octopus V2 是一款由 NexaAIDev 开发的 20 亿参数的开源、轻量级、移动设备的AI语言模型,旨在为智能手机和其他边缘设备提供强大的 AI 功能。

Octopus V2使用了Google Gemma-2B模型作为预训练模型,并采用了全模型训练和LoRA(Low-Rank Adaptation)模型训练两种方法。

Octopus-v2能力如何?

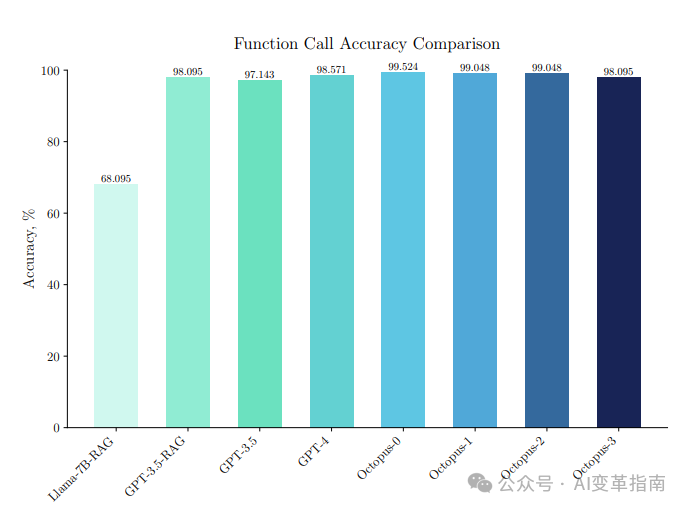

准确性

在Android系统函数调用的基准测试中,Octopus模型展示了极高的准确性。具体来说,Octopus模型在评估数据集上达到了99.524%的准确率。

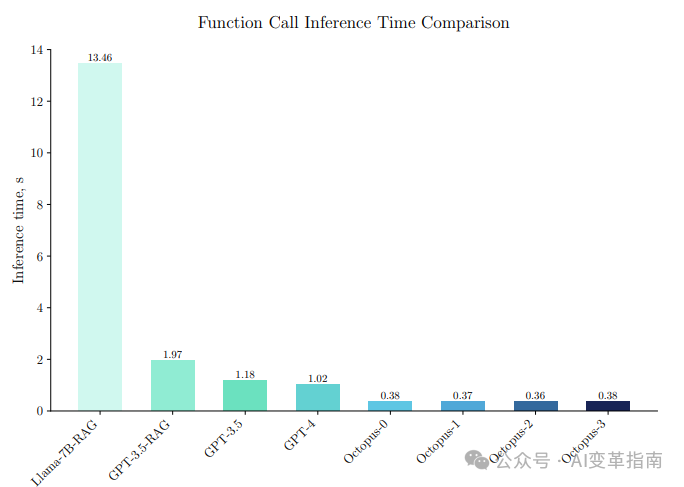

延迟

Octopus模型在延迟方面的表现也非常出色,它能够显著减少函数调用所需的时间。在设备端模型的测试中,Octopus模型能够在1.1到1.7秒内完成对20到30个令牌的典型查询的函数调用。

与现有模型的比

归功于其独特的功能令牌设计。Octopus与“Llama7B + RAG解决方案”相比,快36倍。与依赖于A100/H100 GPU集群的GPT-4-turbo相比,Octopus-v2的速度快168%。

在功能调用准确性方面,Octopus-v2不仅在速度上表现出色,而且在准确性上也超过了“Llama7B + RAG解决方案”

在功能调用准确性上提高了31%。它在基准数据集上的功能调用准确性与GPT-4和RAG + GPT-3.5相当,得分在98%到100%之间。

模型地址:

https://huggingface.co/NexaAIDev/Octopus-v2

论文地址:

https://arxiv.org/abs/2404.01744

分享一个国内免费使用GPT4.0的AI智能问答工具:智答专家。支持AI文本、作图、语音、Sora视频。无需魔法,亲测有效,点击访问

标签:Octopus V2,手机AI

来源:智答专家

发布时间:2024-05-09 15:59

闽公网安备35020302035941号

闽公网安备35020302035941号