如何从 HuggingFace 为 Ollama 导入新模型:Octopus-v2为例

1、关于GGUF格式介绍

是由Georgi Gerganov提出的一种通用的大语言模型存储格式,它支持多种量化级别,它为量化后的模型提供了一个标准化和高效的存储解决方案,使得这些模型可以更容易地集成到各种应用中,尤其是在资源受限的环境中。

2、下载GGUF文件

这里以Octopus-v2为例,

如何下载网上的某个模型

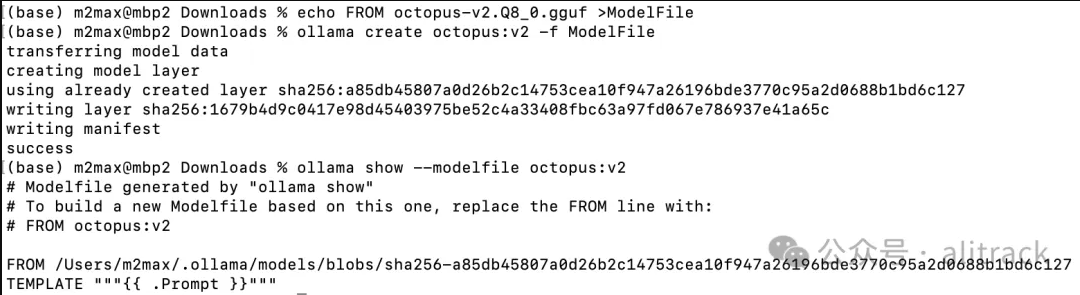

$ echo From Octopus-v2-Q4_K_S.gguf >ModleFile

$ ollama create octopus:v2 -f ModleFile

$ ollama run octopus:v2

分享一个国内免费使用GPT4.0的AI智能问答工具:智答专家。支持AI文本、作图、语音、Sora视频。无需魔法,亲测有效,点击访问

标签:HuggingFace,Ollama,Octopus-v2

来源:智答专家

发布时间:2024-05-13 18:50

闽公网安备35020302035941号

闽公网安备35020302035941号