本地部署AI大模型的好处

数据隐私和安全:确保敏感数据不离开本地环境,降低数据泄露风险,满足严格的数据合规要求。

定制化和灵活性:可以根据自身业务需求和特点,对模型进行更深入的定制和优化,更好地适应特定场景。

低延迟响应:避免网络延迟对实时性要求高的应用产生影响,提供更快速的交互体验。

自主掌控:拥有对模型的完全掌控权,包括升级、维护和调整的决策。

使用方案(目前最容易上手的方案):

ollama

ollama部署耗时

约30分钟

部署步骤

目录

下载ollama

下载模型

下载webUI

完成

详细操作

下载ollama

下载地址:https://ollama.com/

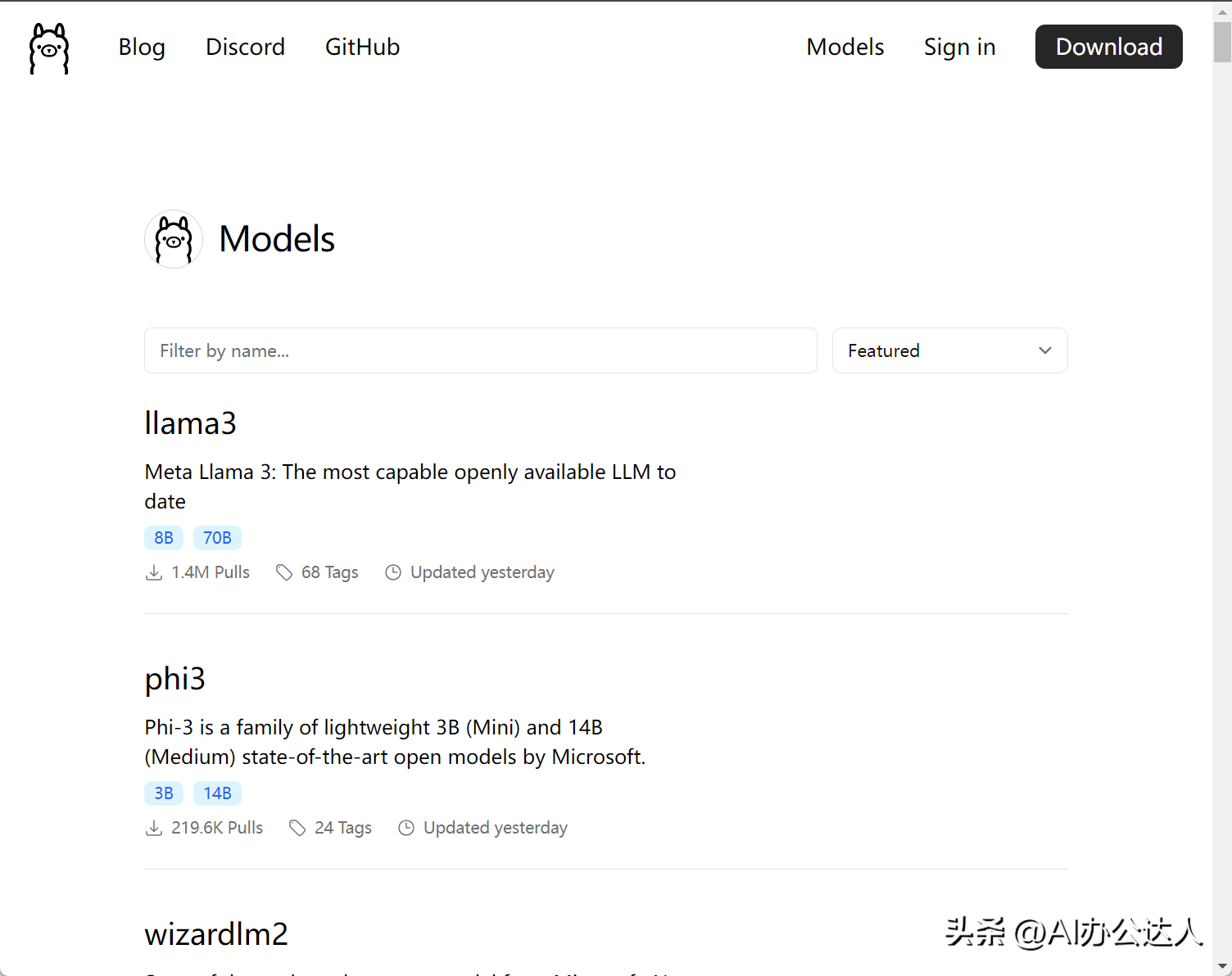

下载模型

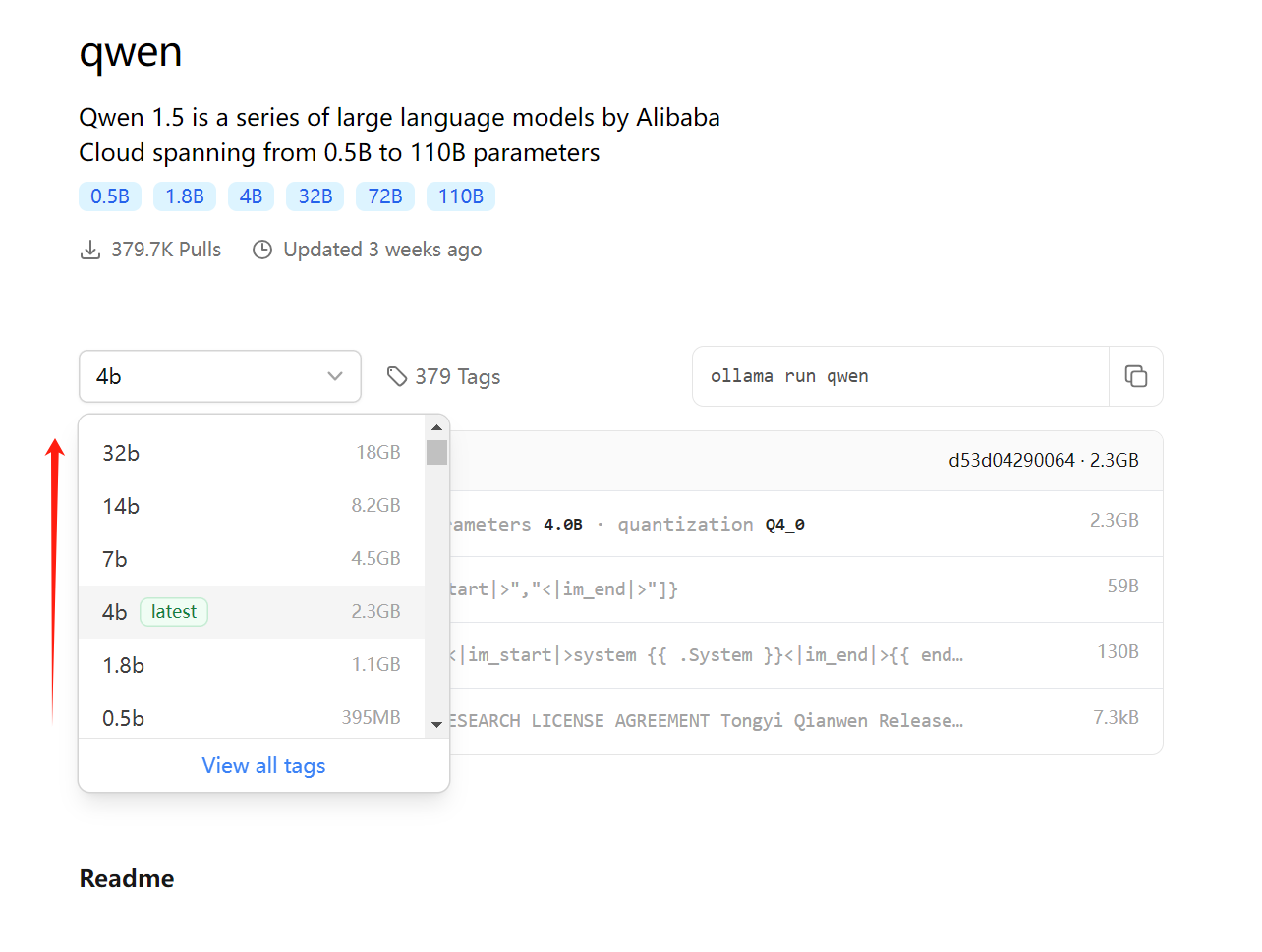

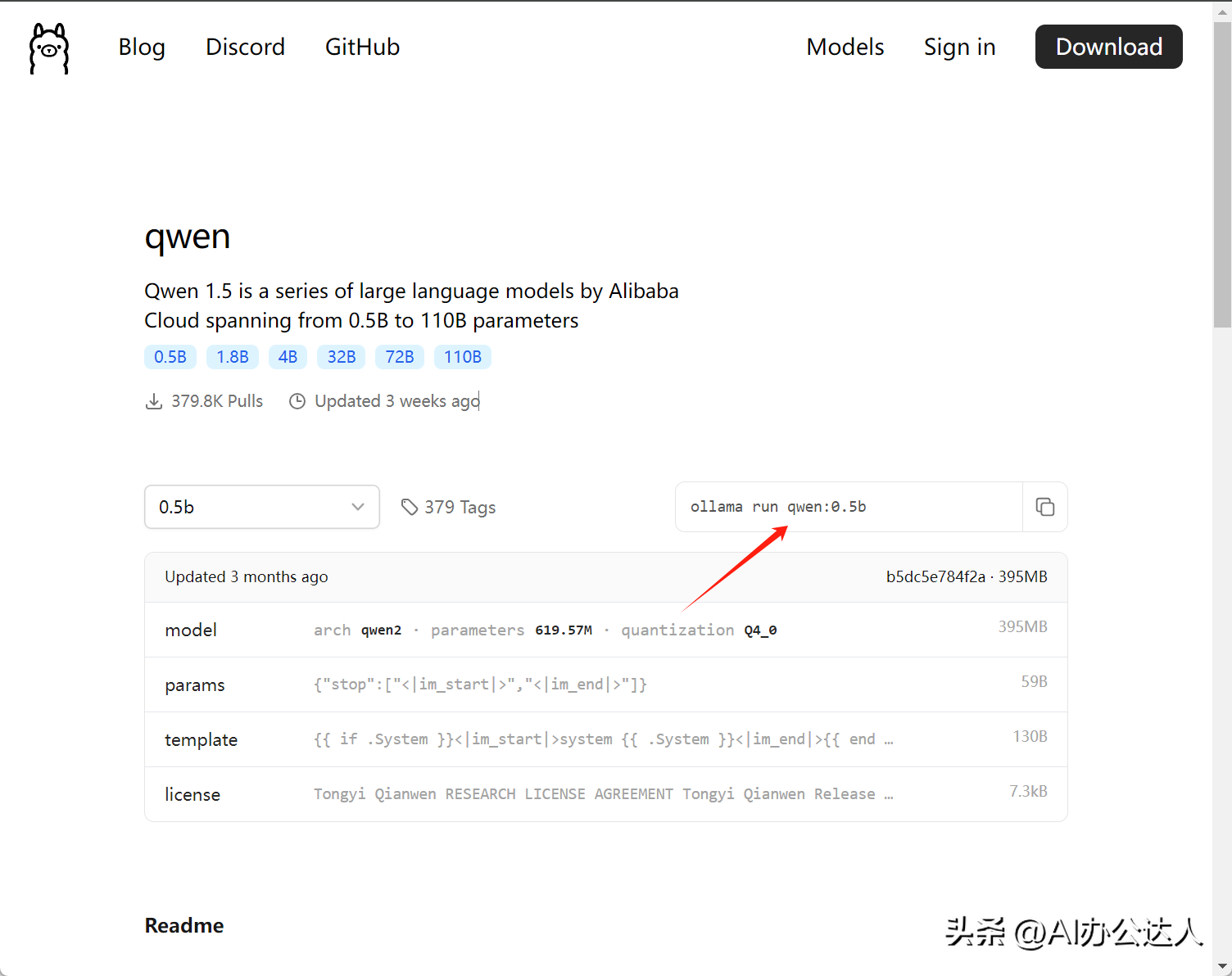

我们找到阿里的通义千文大模型,选择0.5b的

复制上面这段代码

ollama run qwen:0.5b

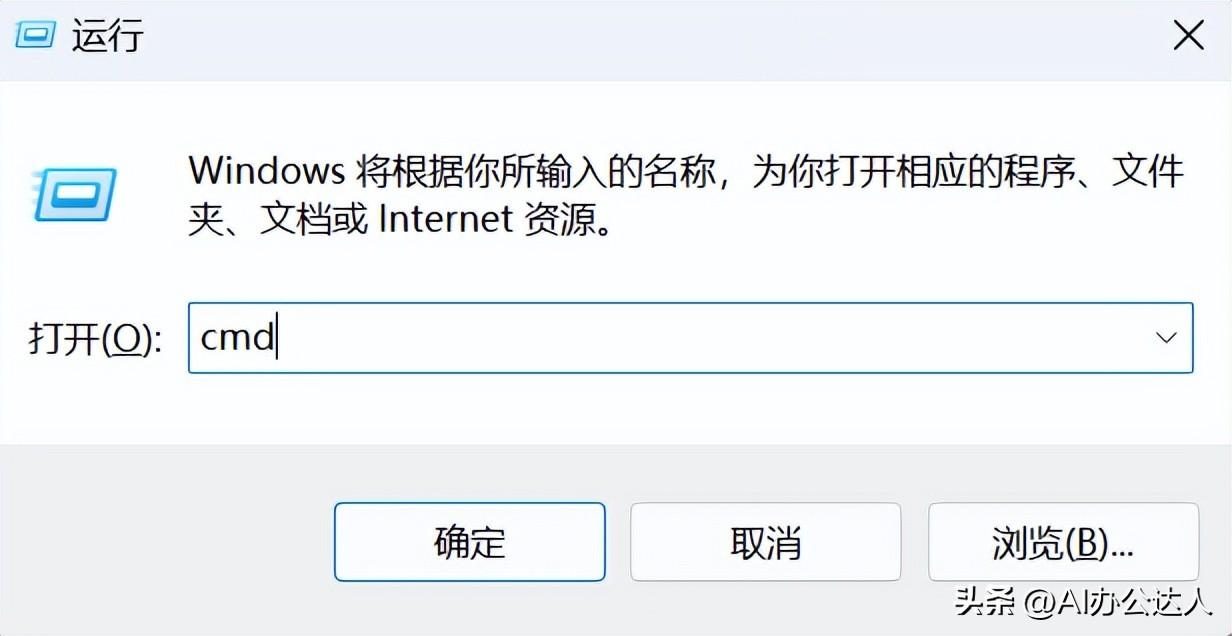

在电脑上,按:窗口键+R,打开运行窗口,如下图:

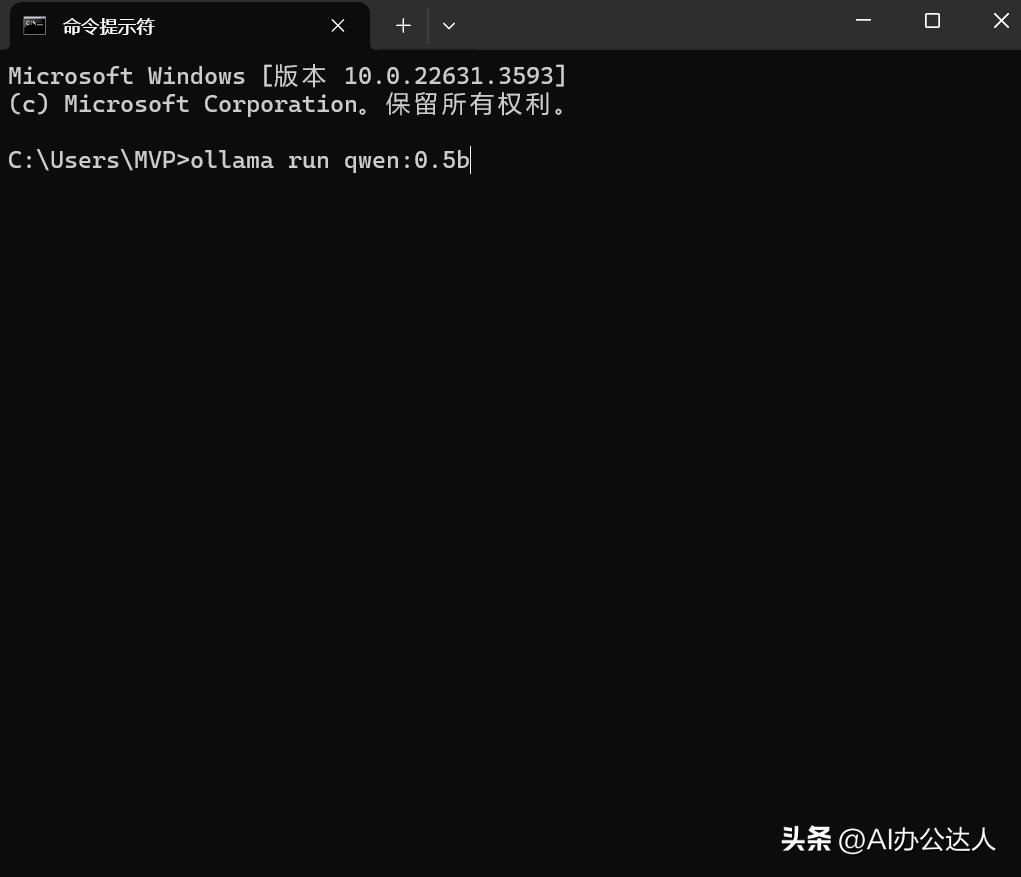

输入:cmd后按回车键,打开命令提示符窗口,如下图所示:

将下面的代码块,复制粘贴到,命令提示符窗口中,按回车

ollama run qwen:0.5b

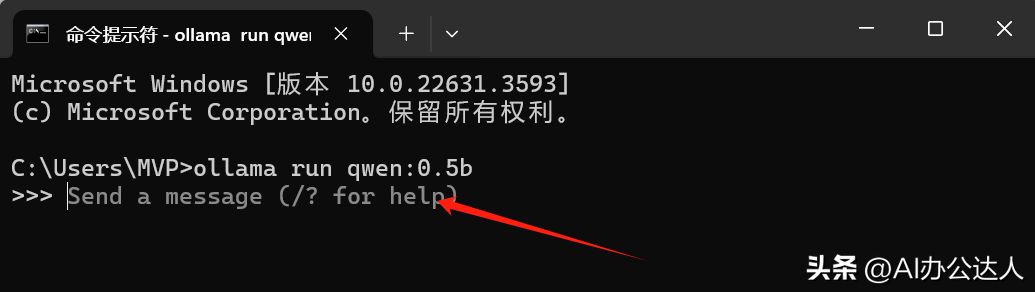

等待几秒钟后,显示如下内容,即安装成功了。

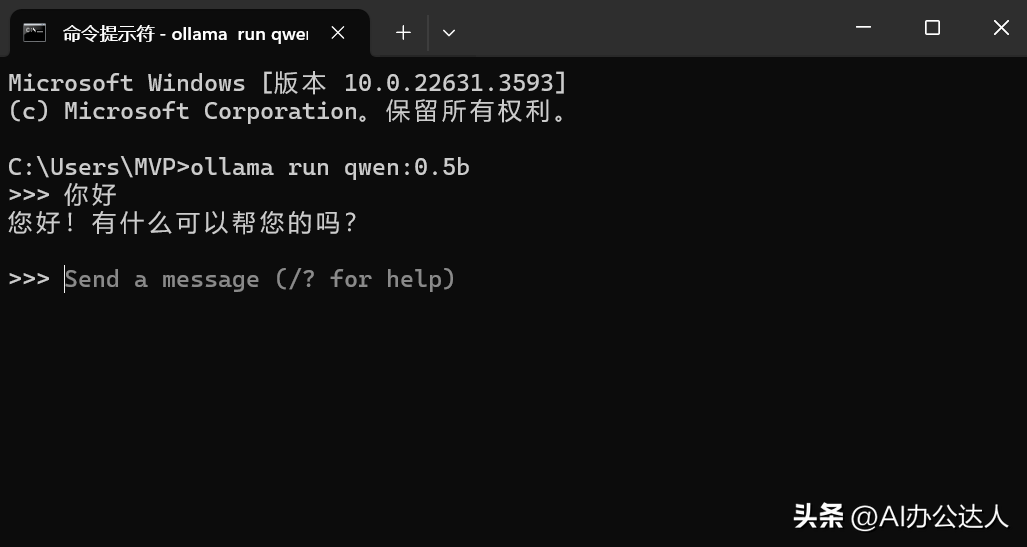

输入一个问候,很快就显示出了AI的回复,如下图:

如果只是简单使用,这一步就可以了。但是如果要有更好的用户体验,则可以安装一个好用的客户端。

客户端安装

以下是官方推荐的一些web和桌面客户端

Web & Desktop

Open WebUI

Enchanted (macOS native)

Hollama

Lollms-Webui

LibreChat

Bionic GPT

HTML UI

Saddle

Chatbot UI

Chatbot UI v2

Typescript UI

Minimalistic React UI for Ollama Models

Ollamac

big-AGI

Cheshire Cat assistant framework

Amica

chatd

Ollama-SwiftUI

Dify.AI

MindMac

NextJS Web Interface for Ollama

Msty

Chatbox

WinForm Ollama Copilot

NextChat with Get Started Doc

Alpaca WebUI

OllamaGUI

OpenAOE

Odin Runes

LLM-X (Progressive Web App)

AnythingLLM (Docker + MacOs/Windows/Linux native app)

Ollama Basic Chat: Uses HyperDiv Reactive UI

Ollama-chats RPG

QA-Pilot (Chat with Code Repository)

ChatOllama (Open Source Chatbot based on Ollama with Knowledge Bases)

CRAG Ollama Chat (Simple Web Search with Corrective RAG)

RAGFlow (Open-source Retrieval-Augmented Generation engine based on deep document understanding)

StreamDeploy (LLM Application Scaffold)

chat (chat web app for teams)

Lobe Chat with Integrating Doc

Ollama RAG Chatbot (Local Chat with multiple PDFs using Ollama and RAG)

BrainSoup (Flexible native client with RAG & multi-agent automation)

macai (macOS client for Ollama, ChatGPT, and other compatible API back-ends)

本地安装Open WebUI

安装dockers

下载docker desktop ,下载地址如下:

https://www.docker.com/products/docker-desktop/

安装成功后,运行dockers desktop

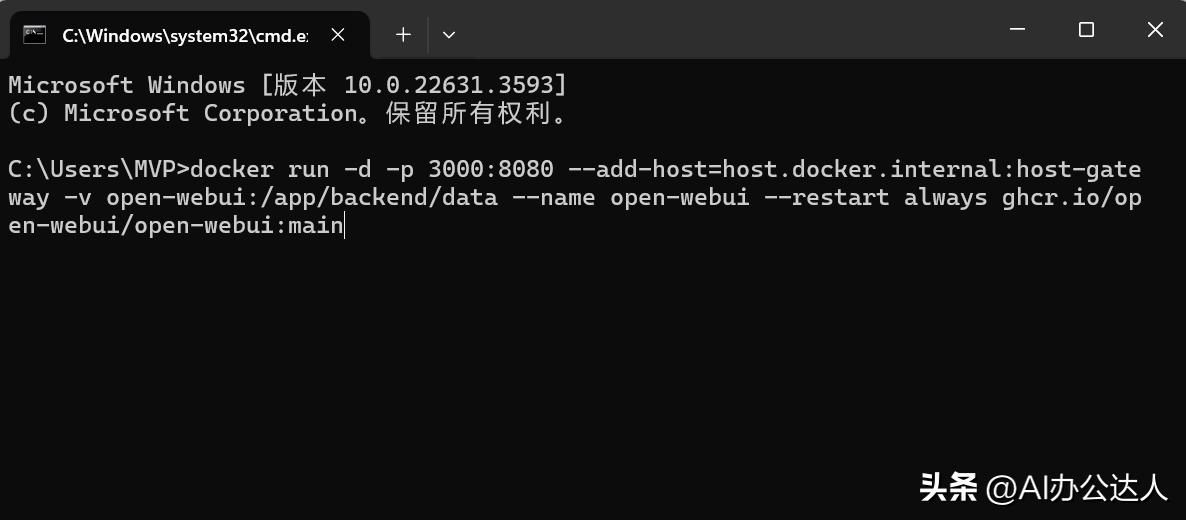

安装openwebui

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

在命令提示符窗口中,粘贴如上代码,如下图所示:

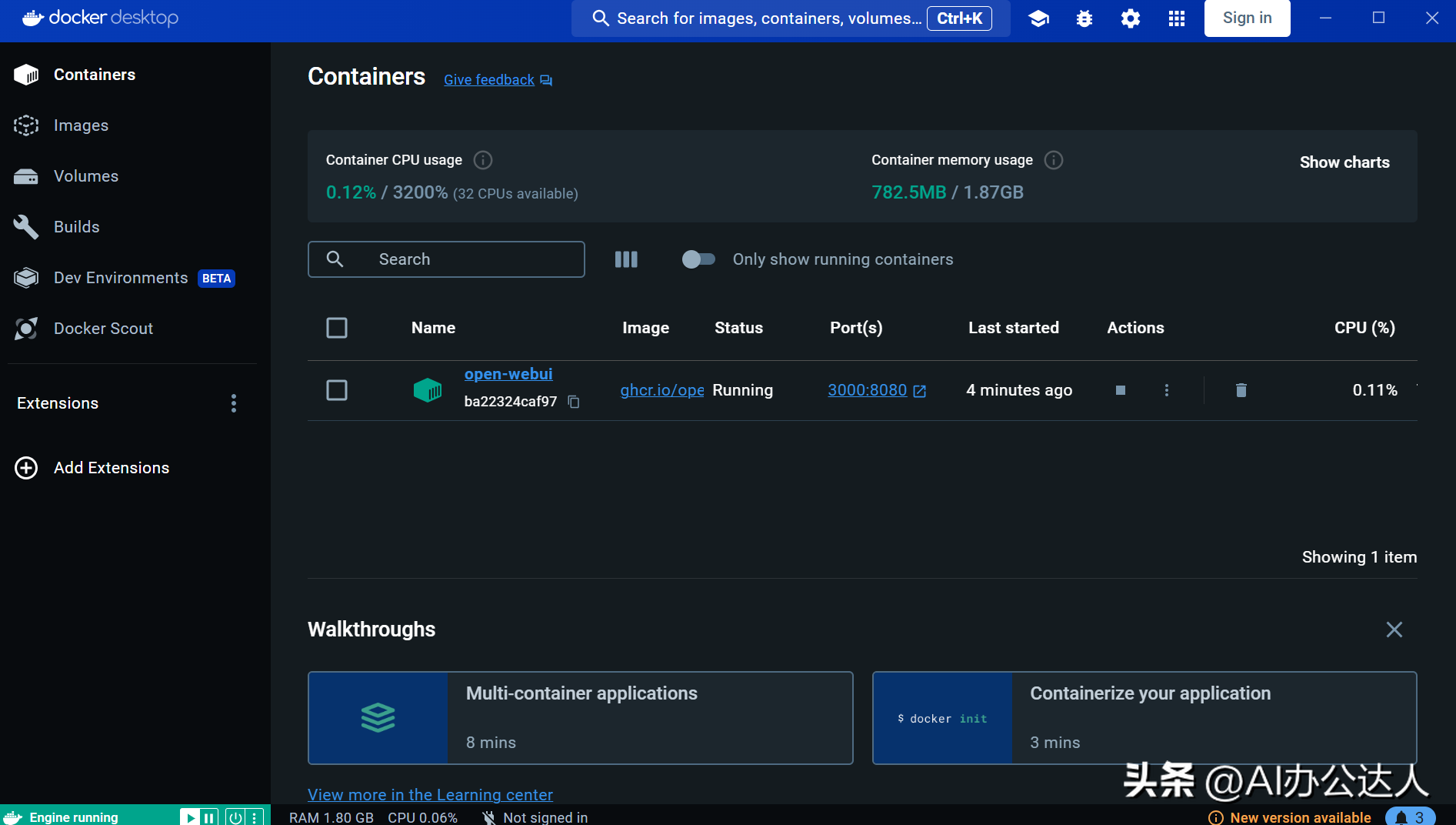

等待安装完成后,打开docker desktop,可以看到容器已经部署成功,如下图所示:

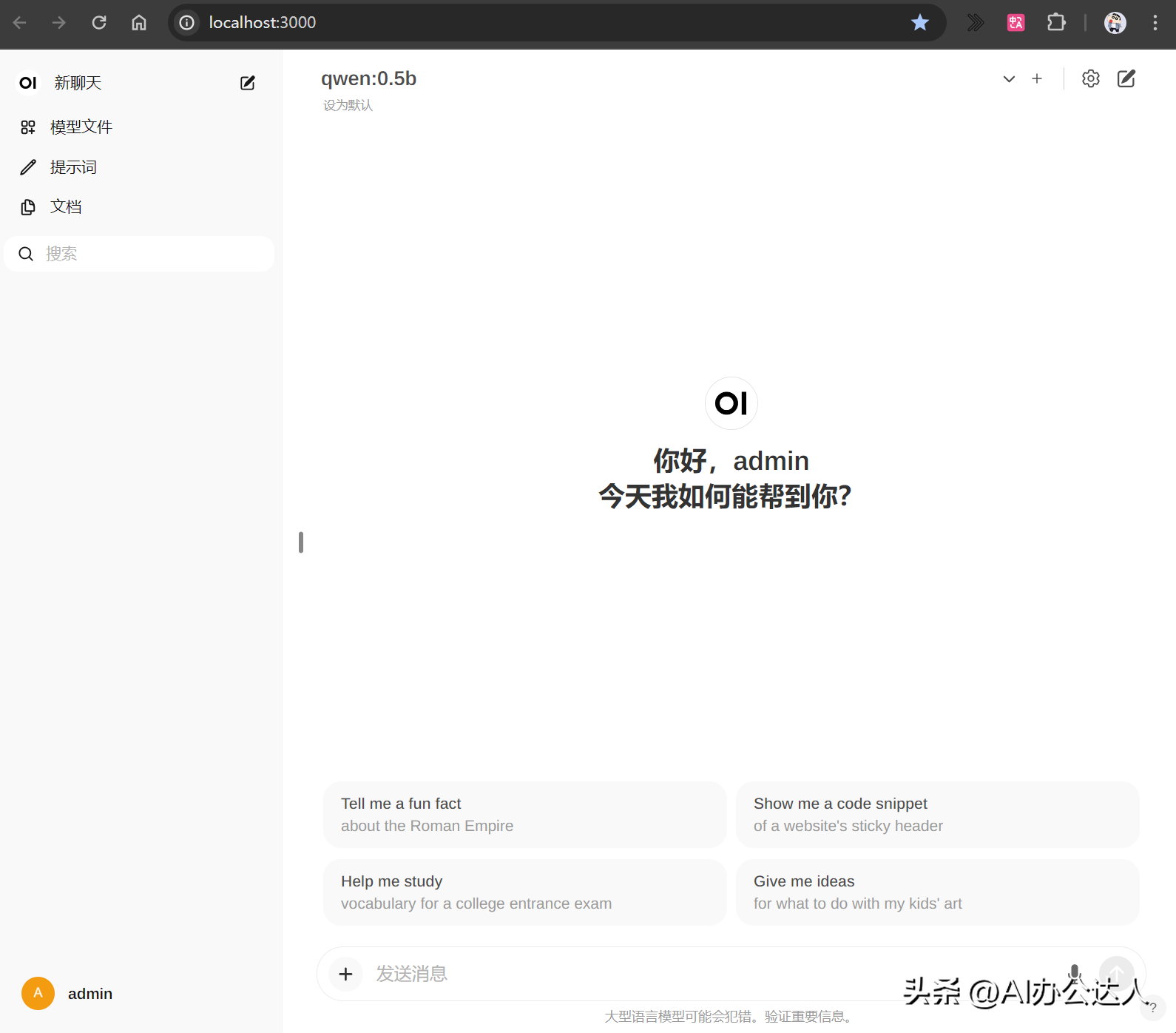

浏览器中输入:localhost:3000 即可打开聊天窗口了,如下图所示:

闽公网安备35020302035941号

闽公网安备35020302035941号